Omvärldsbevakning med hjälp av språkmodeller

| llm | omvärldsbevakning | Lästid: 5 minuter (4702 tecken)

Med språkmodeller går det att lösa omvärldsbevakningen på ett nytt sätt. Istället för nyckelordssökningar som filtrerar ut det som jag troligen är intresserad av görs jobbet av en språkmodell som “nyhetsvärderar” mina viktigaste flöden utifrån en prompt där jag beskriver både mig själv och mina intressen.

(🇬🇧 There is an English translation of this post.)

Omvärldsbevakning har alltid varit en viktig del av mitt jobb, ända sedan jag började som reporter på Ny Teknik hösten 1999. Jag prenumererade på pressutskick, surfade runt bland utländska nättidningar som skrev om internet och teknik och utvecklade med tiden allt bättre arbetsflöden för att göra insamlandet med framför allt filtrerande så smidigt och skräddarsytt som möjligt.

Mer detaljer?

Jag har skrivit en kompletterande text som förklarar med av de tekniska detaljerna.

Till slut hade jag fått till ett så bra system att Internetstiftelsen till och med lät mig skriva Internetguiden Flöden, kvitter och statusuppdateringar – en guide om omvärldsbevakning på nätet.

I inledningen till den refererade jag till journalisten och författaren Nicholas Carr, som i ett blogginlägg hade argumenterat för att bra filter förstärker känslan av informationsstress. Bra filter, menade han, hjälper oss inte bara att hitta en nål i en höstack. Bra filter bygger hela höstackar av nålar där allt är intressant och det är svårt att veta var man ska börja.

Så här i efterhand kan jag konstatera att ett av problemen snarare är att det som gallrades fram inte alls alltid var intressant.

Nyckelordsbevakningar på Google Alerts eller liknande tjänster för “Ericsson” som ett sätt att hålla koll på vad som hände hos telekomjätten gav träffar om alldeles för mycket. Lösningen blev att kombinera med fler nyckelord, både sådana som skulle finnas tillsammans med Ericssons, som WAP och GPRS (those were the days!), eller kombinationer som jag inte var intresserad av.

Problemet är att nyckelord är en lösning som är för oflexibel. Det går inte att beskriva ett intresse för en typ av nyhet i form av några enkla regler.

Åtminstone inte förrän nu. Tack vare språkmodeller går det att bygga lösningar som inte alls är lika statiska.

Vill du läsa mitt nyhetsbrev?

“Vibe monitoring” istället för statiska regler #

När Andrej Karpathy, med bakgrund på både Tesla och OpenAI, började prata om vibe coding i februari gav han mig av bara farten ett begrepp för något som jag experimenterat ett tag: Omvärldsbevakning med hjälp av språkmodeller. Eller som jag kallar det nu, vibe monitoring.

Vibe coding innebär att man beskriver vad man vill programmera för en språkmodell och låter den skriva koden. (Vilket för övrigt är ett sätt som jag gjort flera små skript och annat som löser väldigt specifika behov. Vill du få inspiration till hur man kan jobba på det här sättet är det här blogginlägget av Harper Reed en bra startpunkt.)

Vibe monitoring bygger på samma princip, att jag litar på språkmodellernas känsla för vilken typ av nyheter jag är intresserad av utifrån en beskrivning av mig själv och mina intressen.

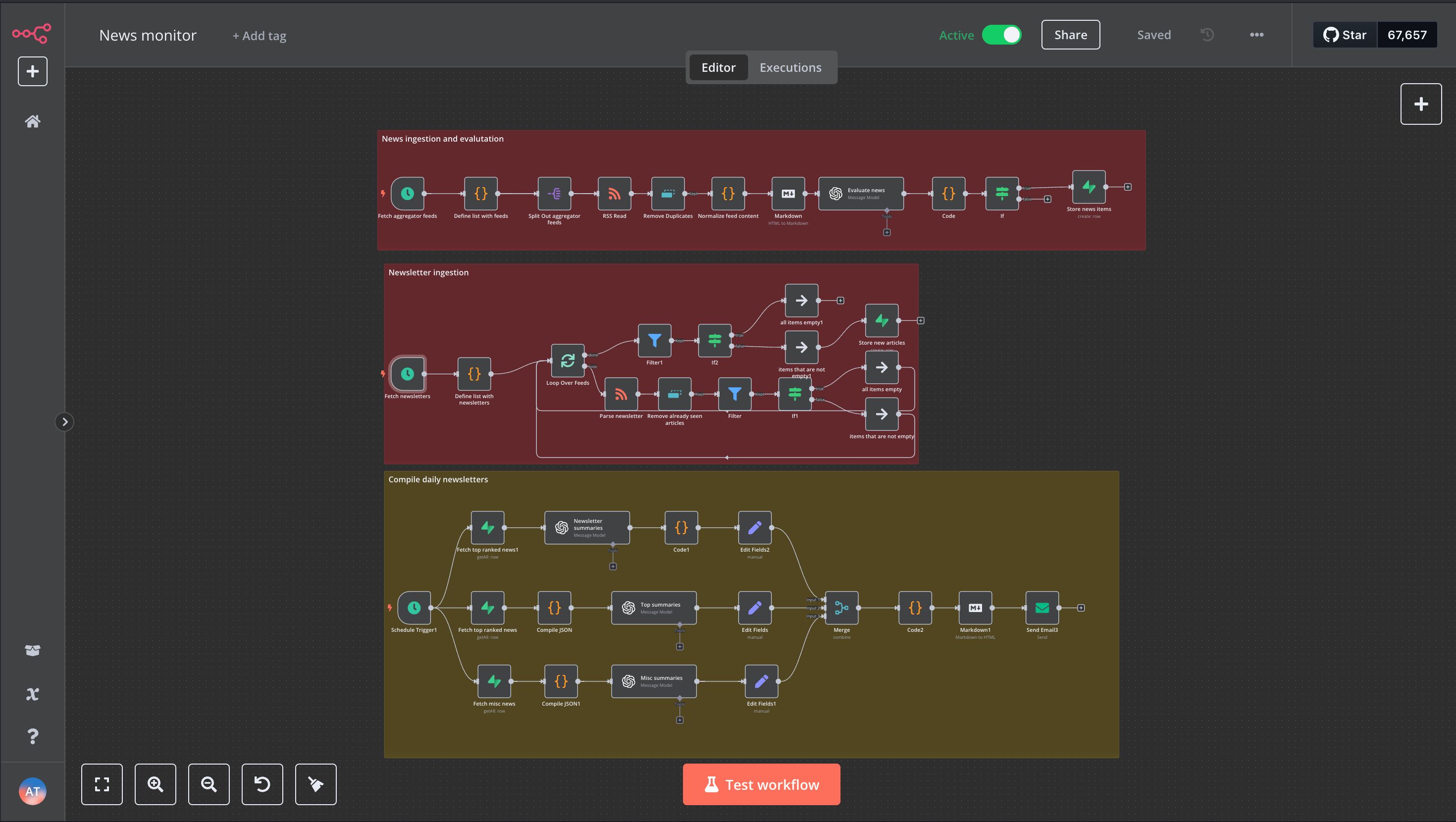

Med hjälp av automationsverktyget n8n hämtar jag nu in nyhetsbrev och nyhetsflöden utifrån samma premisser som jag byggt min omvärldsbevakning på i två decennier: Att följa personer eller redaktioner som skriver om sånt som är relevant för mig, för att sen filtrera ut de specifika grejer som bäst matchar mina intressen.

Det nya är att det inte är hårda regler som står för filtreringen, utan två prompter. Båda beskriver vem jag är, vad jag jobbar med, vilka ämnen jag är intresserad av och i vilka tidningar och nyhetsbrev jag ofta hittar det jag ledar efter. I den ena prompten kompletteras den bakgrundsinformationen med en instruktion om att sammanfatta innehåll, i den andra att avgöra om en artikel matchar mina intressen eller inte. De är formulerade på samma sätt som jag skulle beskriva det här för en kollega.

Sammanfattnings-prompten använder jag för de flöden där jag vet att jag vill läsa det mesta, men inte har tid att ta mig igenom allt. I första hand handlar det här om de nyhetsbrev jag prenumererar på, men också några kanaler för pressmeddelandet och rapporter från företag och organisationer som är viktiga för mig.

Sorterings-prompten tar hand om innehållet i de mer omfattande nyhetsflödena, som exempelvis Techmeme, Hacker News, Wired och The Verge. Det här är flöden som rör sig i de ämnesområden där jag har mina intressen, men där långtifrån allt är en perfekt match och därför “slängs” dessutom en majoritet av de här artiklarna.

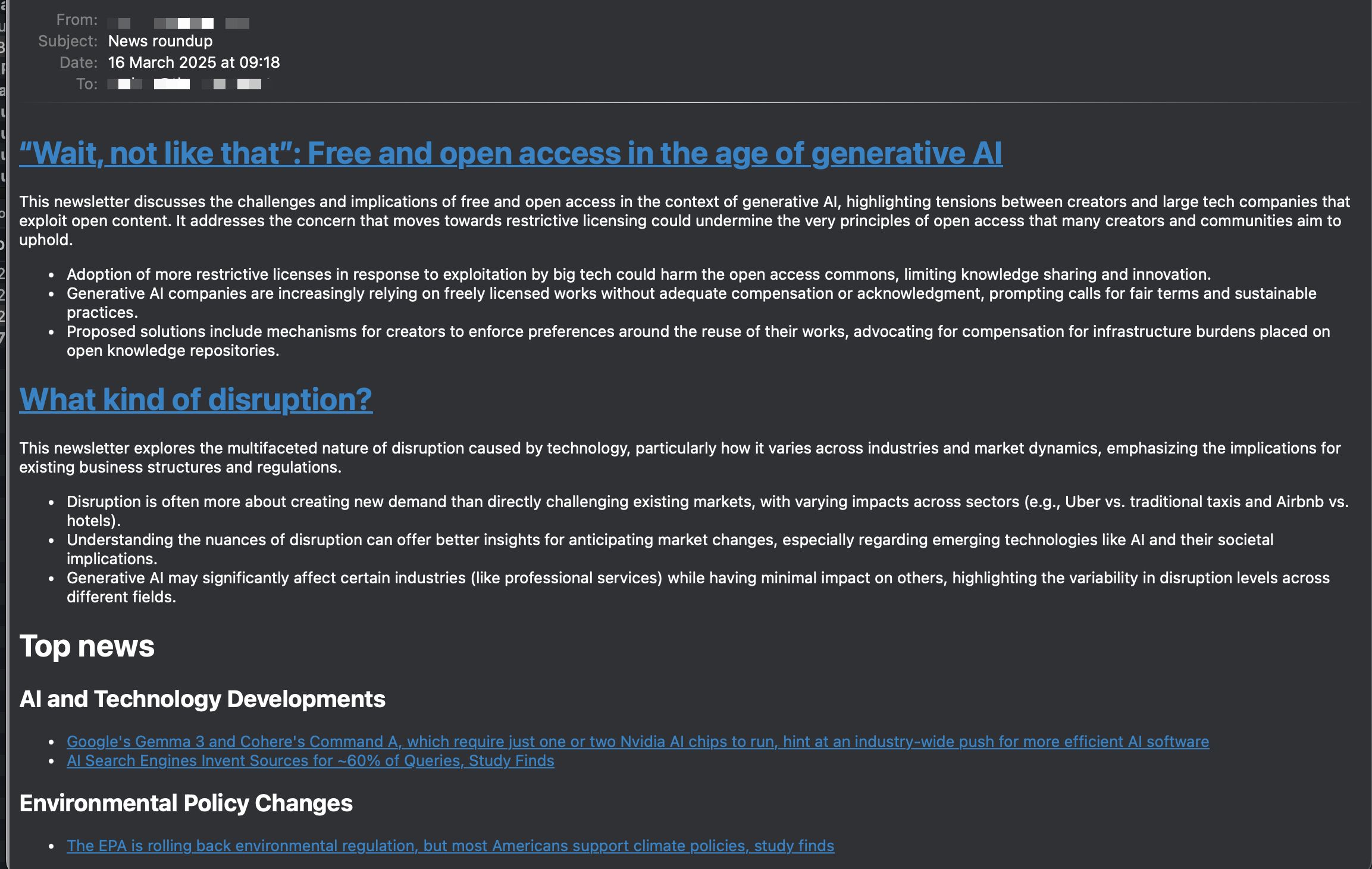

Allt det modellerna spottar ur sig sammanställs i ett mail som dyker upp i mitt inkorg varje morgon, uppdelat i tre delar där de två senare dessutom grupperar länkar om liknande ämnen under egna rubriker:

- En sammanfattning av nya texter i nyhetsbreven jag prenumererar på.

- En del med de nyheter som min sorterings-prompt bedömt att jag sannolikt är mest intresserad av.

- Och slutligen länkar till några texter som inte är fullt lika troligt matchar mina intressen.

På det här sättet får jag en översikt över det som dykt upp i mina flöden det senaste dygnet och kan utifrån det bestämma om det finns något jag vill läsa direkt eller som ska sparas i läsa senare-högen.

Kostnaden för det här är försumbar. Jag kör en egen installation av n8n på en server jag hyr till annat, men det skulle också gå att köra lokalt i den egna datorn. Och till OpenAI går det 20-60 öre per dygn för att GPT-4o Mini ska sammanfatta och nyhetsvärdera det som dyker upp i mina flöden.

En liten notering vid sidan av så här på slutet, och som egentligen kan bli ett blogginlägg i sig själv: Det här arbetssättet är en bra illustration på att språkmodellernas probabilistiska drag – att de bygger på statistik och sannolikheter och därmed inte är så bra på fakta – inte nödvändigtvis är ett problem i sig självt. Det finns gott om användningsområden där de “kreativa egenskaperna” är precis det man vill ha. Det handlar som så ofta om att använda rätt verktyg till rätt sak.